Cách tiếp cận phổ biến hiện tại là mô hình ngôn ngữ lớn càng lớn càng tốt, với hy vọng rằng hiệu suất sẽ tăng theo lượng dữ liệu và sức mạnh tính toán. Tuy nhiên, các báo cáo gần đây đã chỉ ra rằng các mô hình lớn như GPT-5 đang đối mặt với thách thức về hiệu suất giảm dần trong quá trình đào tạo.

Vấn đề này đưa ra mối lo ngại về việc các hệ thống AI có thể phải tuân theo quy luật hiệu suất giảm dần, làm giảm lợi nhuận từ việc cải thiện hiệu suất trong các mô hình mới. Thêm vào đó, sự hạn chế của dữ liệu mới chất lượng cao cũng tạo ra một thách thức khác cho việc phát triển AI.

Tuy nhiên, không phải ai cũng đồng ý rằng việc mở rộng quy mô là điều cần thiết. Có những nghiên cứu cho thấy các mô hình hiện tại đã có khả năng vượt trội so với chuyên gia trong nhiều nhiệm vụ phức tạp. Điều này đặt ra câu hỏi liệu việc mở rộng quy mô nhiều hơn có thực sự cần thiết hay không.

Dù vậy, việc mở rộng quy mô, nâng cao kỹ năng hay áp dụng các phương pháp mới đều hứa hẹn mang lại những tiến bộ trong tương lai của AI. Thách thức lớn nhất là đảm bảo rằng tiến trình phát triển AI vẫn đảm bảo trách nhiệm và có tác động tích cực đối với mọi người. #AI #Phát triển #Quy mô #Hiệu suất #Cuộc cách mạngAI. Nguồn: https://venturebeat.com/ai/the-end-of-ai-scaling-may-not-be-nigh-heres-whats-next/

Tham gia các bản tin hàng ngày và hàng tuần của chúng tôi để có những cập nhật mới nhất và nội dung độc quyền về phạm vi phủ sóng AI hàng đầu trong ngành. Tìm hiểu thêm

Khi hệ thống AI đạt được hiệu suất siêu phàm trong các nhiệm vụ ngày càng phức tạp, ngành này đang phải vật lộn với việc liệu các mô hình lớn hơn có khả thi hay không – hoặc liệu sự đổi mới có phải đi theo một con đường khác hay không.

Cách tiếp cận chung để phát triển mô hình ngôn ngữ lớn (LLM) là càng lớn thì càng tốt và hiệu suất sẽ tăng theo nhiều dữ liệu hơn và nhiều sức mạnh tính toán hơn. Tuy nhiên, các cuộc thảo luận trên phương tiện truyền thông gần đây đã tập trung vào việc LLM đang tiến đến giới hạn của họ như thế nào. “AI có đang va vào tường không?” The Verge được hỏi trong khi Reuters đã báo cáo rằng “OpenAI và những tổ chức khác đang tìm kiếm con đường mới dẫn đến AI thông minh hơn khi các phương pháp hiện tại gặp phải những hạn chế.”

Mối lo ngại là việc mở rộng quy mô, vốn đã thúc đẩy những tiến bộ trong nhiều năm, có thể không mở rộng sang thế hệ mô hình tiếp theo. Báo cáo cho thấy rằng việc phát triển các mô hình tiên phong như GPT-5, vốn đẩy các giới hạn hiện tại của AI, có thể phải đối mặt với những thách thức do mức tăng hiệu suất giảm dần trong quá trình đào tạo trước. Thông tin đã báo cáo về những thách thức này tại OpenAI và Bloomberg che phủ tin tức tương tự tại Google và Anthropic.

Vấn đề này đã dẫn đến mối lo ngại rằng các hệ thống này có thể phải tuân theo quy luật hiệu suất giảm dần – trong đó mỗi đơn vị đầu vào được thêm vào sẽ mang lại lợi nhuận nhỏ hơn dần dần. Khi LLM phát triển lớn hơn, chi phí để có được dữ liệu đào tạo chất lượng cao và cơ sở hạ tầng mở rộng quy mô sẽ tăng theo cấp số nhân, làm giảm lợi nhuận từ việc cải thiện hiệu suất trong các mô hình mới. Thêm thách thức này là sự hạn chế của dữ liệu mới chất lượng cao, vì phần lớn thông tin có thể truy cập đã được tích hợp vào các tập dữ liệu đào tạo hiện có.

Điều này không có nghĩa là sự kết thúc tăng hiệu suất cho AI. Nó đơn giản có nghĩa là để duy trì sự tiến bộ, cần có kỹ thuật sâu hơn thông qua đổi mới trong kiến trúc mô hình, kỹ thuật tối ưu hóa và sử dụng dữ liệu.

Học từ định luật Moore

Mô hình lợi nhuận giảm dần tương tự cũng xuất hiện trong ngành bán dẫn. Trong nhiều thập kỷ, ngành công nghiệp này đã được hưởng lợi từ Định luật Moore, dự đoán rằng số lượng bóng bán dẫn sẽ tăng gấp đôi sau mỗi 18 đến 24 tháng, thúc đẩy những cải tiến hiệu suất đáng kể thông qua các thiết kế nhỏ hơn và hiệu quả hơn. Điều này cuối cùng cũng đạt được lợi nhuận giảm dần, bắt đầu từ đâu đó giữa năm 2005 và 2007 bởi vì Chia tỷ lệ Dennard — nguyên tắc bóng bán dẫn co lại cũng làm giảm mức tiêu thụ điện năng— đã đạt đến giới hạn, điều này thúc đẩy các dự đoán về cái chết của định luật Moore.

Tôi đã có cái nhìn cận cảnh về vấn đề này khi làm việc với AMD từ năm 2012-2022. Vấn đề này không có nghĩa là chất bán dẫn – và các bộ xử lý máy tính mở rộng – đã ngừng đạt được những cải tiến về hiệu suất từ thế hệ này sang thế hệ tiếp theo. Điều đó có nghĩa là những cải tiến đến từ thiết kế chiplet, bộ nhớ băng thông cao, bộ chuyển mạch quang, nhiều bộ nhớ đệm hơn và kiến trúc máy tính được tăng tốc hơn là thu nhỏ quy mô bóng bán dẫn.

Những con đường mới để tiến bộ

Hiện tượng tương tự đã được quan sát thấy với LLM hiện tại. Các mô hình AI đa phương thức như GPT-4o, Claude 3.5 và Gemini 1.5 đã chứng minh sức mạnh của việc tích hợp khả năng hiểu văn bản và hình ảnh, cho phép cải tiến các tác vụ phức tạp như phân tích video và chú thích hình ảnh theo ngữ cảnh. Việc điều chỉnh nhiều hơn các thuật toán cho cả đào tạo và suy luận sẽ dẫn đến tăng hiệu suất hơn nữa. Các công nghệ tác nhân, cho phép LLM thực hiện các nhiệm vụ một cách tự chủ và phối hợp liền mạch với các hệ thống khác, sẽ sớm mở rộng đáng kể các ứng dụng thực tế của chúng.

Những đột phá về mô hình trong tương lai có thể nảy sinh từ một hoặc nhiều thiết kế kiến trúc AI lai kết hợp lý luận biểu tượng với mạng lưới thần kinh. Mô hình suy luận o1 của OpenAI đã cho thấy tiềm năng tích hợp mô hình và mở rộng hiệu suất. Mặc dù bây giờ chỉ mới nổi lên từ giai đoạn phát triển ban đầu, tính toán lượng tử hứa hẹn sẽ tăng tốc quá trình đào tạo và suy luận AI bằng cách giải quyết các tắc nghẽn tính toán hiện tại.

Bức tường mở rộng được nhận thức khó có thể ngăn cản những lợi ích trong tương lai, vì cộng đồng nghiên cứu AI đã liên tục chứng minh sự khéo léo của mình trong việc vượt qua các thách thức và mở ra những khả năng mới cũng như những tiến bộ về hiệu suất.

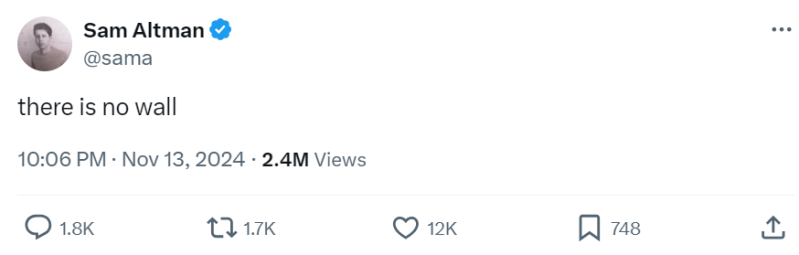

Trên thực tế, không phải ai cũng đồng ý rằng thậm chí còn có một bức tường tỷ lệ. Giám đốc điều hành OpenAI Sam Altman đã đưa ra quan điểm ngắn gọn của mình: “Không có bức tường nào cả”.

Phát biểu trên “Nhật ký của một CEO” podcast, cựu CEO Google và đồng tác giả của Sáng Thế Ký Về cơ bản, Eric Schmidt đồng ý với Altman, nói rằng ông không tin rằng có một bức tường ngăn – ít nhất là sẽ không có bức tường nào trong vòng 5 năm tới. “Trong 5 năm, bạn sẽ có thêm hai hoặc ba lượt quay của những chiếc LLM này. Mỗi một trong số các tay quay này trông giống như hệ số hai, hệ số ba, hệ số bốn của khả năng, vì vậy hãy giả sử việc quay tay quay trên tất cả các hệ thống này sẽ mạnh hơn gấp 50 lần hoặc 100 lần,” ông nói.

Các nhà đổi mới AI hàng đầu vẫn lạc quan về tốc độ tiến bộ cũng như tiềm năng của các phương pháp mới. Sự lạc quan này thể hiện rõ ở một cuộc trò chuyện gần đây TRÊN “Podcast của Lenny” với CPO Kevin Weil của OpenAI và CPO Anthropic Mike Krieger.

Trong cuộc thảo luận này, Krieger mô tả rằng những gì OpenAI và Anthropic đang làm ngày nay “giống như phép thuật”, nhưng thừa nhận rằng chỉ sau 12 tháng nữa, “chúng tôi sẽ nhìn lại và nói, bạn có tin rằng chúng tôi đã sử dụng thứ rác rưởi đó không? … Đó là tốc độ phát triển (sự phát triển AI).”

Đó là sự thật — nó thực sự giống như phép thuật, như tôi đã trải nghiệm gần đây khi sử dụng OpenAI Chế độ giọng nói nâng cao. Nói chuyện với ‘Juniper’ mang lại cảm giác hoàn toàn tự nhiên và liền mạch, cho thấy AI đang phát triển như thế nào để hiểu và phản hồi bằng cảm xúc cũng như sắc thái trong các cuộc trò chuyện thời gian thực.

Krieger cũng thảo luận về mô hình o1 gần đây, coi đây là “một cách mới để mở rộng quy mô trí thông minh và chúng tôi cảm thấy như mình chỉ mới bắt đầu”. Ông nói thêm: “Các mô hình sẽ ngày càng thông minh hơn với tốc độ nhanh chóng”.

Những tiến bộ được mong đợi này cho thấy rằng mặc dù các phương pháp mở rộng quy mô truyền thống có thể phải đối mặt với hoặc không phải đối mặt với tình trạng lợi nhuận giảm dần trong thời gian tới, lĩnh vực AI vẫn sẵn sàng cho những đột phá liên tục thông qua các phương pháp mới và kỹ thuật sáng tạo.

Liệu việc mở rộng quy mô có quan trọng không?

Trong khi những thách thức về quy mô chiếm ưu thế trong phần lớn các cuộc thảo luận hiện nay xung quanh LLM, các nghiên cứu gần đây cho thấy rằng các mô hình hiện tại đã có khả năng mang lại những kết quả phi thường, đặt ra một câu hỏi mang tính khiêu khích là liệu việc mở rộng quy mô nhiều hơn có quan trọng hay không.

MỘT nghiên cứu gần đây dự đoán rằng ChatGPT sẽ giúp các bác sĩ chẩn đoán khi gặp những trường hợp bệnh nhân phức tạp. Được tiến hành với phiên bản đầu tiên của GPT-4, nghiên cứu đã so sánh khả năng chẩn đoán của ChatGPT với khả năng chẩn đoán của các bác sĩ có và không có sự trợ giúp của AI. Một kết quả đáng ngạc nhiên cho thấy chỉ riêng ChatGPT đã vượt trội hơn đáng kể so với cả hai nhóm, bao gồm cả các bác sĩ sử dụng viện trợ AI. Có một số lý do giải thích cho điều này, từ việc các bác sĩ thiếu hiểu biết về cách sử dụng bot tốt nhất cho đến việc họ tin rằng kiến thức, kinh nghiệm và trực giác của họ vốn đã vượt trội.

Đây không phải là nghiên cứu đầu tiên cho thấy bot đạt được kết quả vượt trội so với các chuyên gia. VentureBeat đã báo cáo trên một nghiên cứu hồi đầu năm nay cho thấy LLM có thể tiến hành phân tích báo cáo tài chính với độ chính xác sánh ngang – và thậm chí vượt qua – của các nhà phân tích chuyên nghiệp. Đồng thời sử dụng GPT-4, một mục tiêu khác là dự đoán mức tăng trưởng thu nhập trong tương lai. GPT-4 đạt độ chính xác 60% trong việc dự đoán hướng thu nhập trong tương lai, cao hơn đáng kể so với phạm vi dự báo của nhà phân tích con người là 53 đến 57%.

Đáng chú ý là cả hai ví dụ này đều dựa trên các mô hình đã lỗi thời. Những kết quả này nhấn mạnh rằng ngay cả khi không có những đột phá về quy mô mới, các LLM hiện tại vẫn có khả năng vượt trội so với các chuyên gia trong các nhiệm vụ phức tạp, thách thức các giả định về sự cần thiết phải mở rộng quy mô hơn nữa để đạt được kết quả có tác động.

Mở rộng quy mô, kỹ năng hoặc cả hai

Những ví dụ này cho thấy rằng LLM hiện tại đã có khả năng cao, nhưng chỉ mở rộng quy mô có thể không phải là con đường duy nhất cho sự đổi mới trong tương lai. Nhưng với khả năng mở rộng quy mô hơn và các kỹ thuật mới nổi khác hứa hẹn cải thiện hiệu suất, sự lạc quan của Schmidt phản ánh tốc độ phát triển nhanh chóng của AI, cho thấy rằng chỉ trong 5 năm nữa, các mô hình có thể phát triển thành đa hình, trả lời liền mạch các câu hỏi phức tạp trên nhiều lĩnh vực.

Cho dù thông qua mở rộng quy mô, nâng cao kỹ năng hay các phương pháp hoàn toàn mới, biên giới tiếp theo của AI hứa hẹn sẽ biến đổi không chỉ bản thân công nghệ mà còn cả vai trò của nó trong cuộc sống của chúng ta. Thách thức phía trước là đảm bảo rằng tiến trình vẫn có trách nhiệm, công bằng và có tác động đối với mọi người.

Gary Grossman là EVP phụ trách thực hành công nghệ tại Edelman và lãnh đạo toàn cầu của Trung tâm Xuất sắc AI Edelman.

Người đưa ra quyết định dữ liệu

Chào mừng đến với cộng đồng VentureBeat!

DataDecisionMakers là nơi các chuyên gia, bao gồm cả những người kỹ thuật làm công việc về dữ liệu, có thể chia sẻ những hiểu biết sâu sắc và đổi mới liên quan đến dữ liệu.

Nếu bạn muốn đọc về những ý tưởng tiên tiến và thông tin cập nhật, các phương pháp hay nhất cũng như tương lai của dữ liệu và công nghệ dữ liệu, hãy tham gia cùng chúng tôi tại DataDecisionMakers.

Bạn thậm chí có thể cân nhắc đóng góp một bài viết của riêng bạn!

[ad_2]

[ad_2]