Join our daily and weekly newsletters for the latest updates and exclusive content on industry-leading AI coverage. Learn More

SambaNova Systems and Gradio have unveiled a new integration that allows developers to access one of the fastest AI inference platforms with just a few lines of code. This partnership aims to make high-performance AI models more accessible and speed up the adoption of artificial intelligence among developers and businesses.

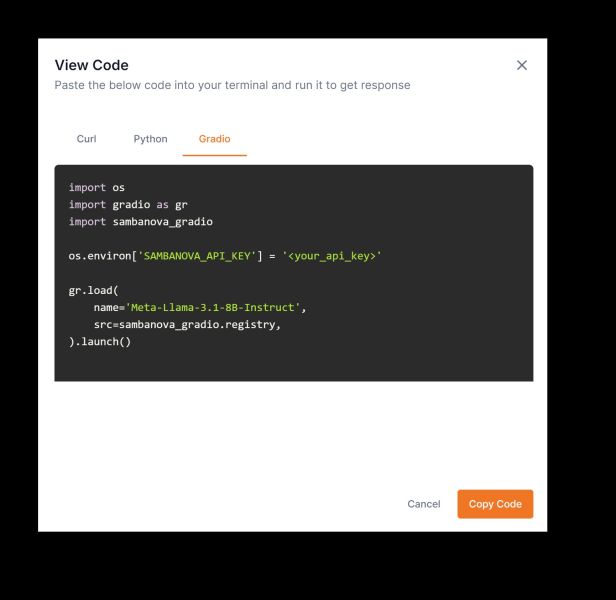

“This integration makes it easy for developers to copy code from the SambaNova playground and get a Gradio web app running in minutes with just a few lines of code,” Ahsen Khaliq, ML Growth Lead at Gradio, said in an interview with VentureBeat. “Powered by SambaNova Cloud for super-fast inference, this means a great user experience for developers and end-users alike.”

The SambaNova-Gradio integration enables users to create web applications powered by SambaNova’s high-speed AI models using Gradio’s gr.load() function. Developers can now quickly generate a chat interface connected to SambaNova’s models, making it easier to work with advanced AI systems.

Beyond GPUs: The rise of dataflow architecture in AI processing

SambaNova, a Silicon Valley startup backed by SoftBank and BlackRock, has been making waves in the AI hardware space with its dataflow architecture chips. These chips are designed to outperform traditional GPUs for AI workloads, with the company claiming to offer the “world’s fastest AI inference service.”

SambaNova’s platform can run Meta’s Llama 3.1 405B model at 132 tokens per second at full precision, a speed that is particularly crucial for enterprises looking to deploy AI at scale.

This development comes as the AI infrastructure market heats up, with startups like SambaNova, Groq, and Cerebras challenging Nvidia’s dominance in AI chips. These new entrants are focusing on inference — the production stage of AI where models generate outputs based on their training — which is expected to become a larger market than model training.

From code to cloud: The simplification of AI application development

For developers, the SambaNova-Gradio integration offers a frictionless entry point to experiment with high-performance AI. Users can access SambaNova’s free tier to wrap any supported model into a web app and host it themselves within minutes. This ease of use mirrors recent industry trends aimed at simplifying AI application development.

The integration currently supports Meta’s Llama 3.1 family of models, including the massive 405B parameter version. SambaNova claims to be the only provider running this model at full 16-bit precision at high speeds, a level of fidelity that could be particularly attractive for applications requiring high accuracy, such as in healthcare or financial services.

The hidden costs of AI: Navigating speed, scale, and sustainability

While the integration makes high-performance AI more accessible, questions remain about the long-term effects of the ongoing AI chip competition. As companies race to offer faster processing speeds, concerns about energy use, scalability, and environmental impact grow.

The focus on raw performance metrics like tokens per second, while important, may overshadow other crucial factors in AI deployment. As enterprises integrate AI into their operations, they will need to balance speed with sustainability, considering the total cost of ownership, including energy consumption and cooling requirements.

Additionally, the software ecosystem supporting these new AI chips will significantly influence their adoption. Although SambaNova and others offer powerful hardware, Nvidia’s CUDA ecosystem maintains an edge with its wide range of optimized libraries and tools that many AI developers already know well.

As the AI infrastructure market continues to evolve, collaborations like the SambaNova-Gradio integration may become increasingly common. These partnerships have the potential to foster innovation and competition in a field that promises to transform industries across the board. However, the true test will be in how these technologies translate into real-world applications and whether they can deliver on the promise of more accessible, efficient, and powerful AI for all.

[ad_2]

[ad_2]