#Apple #lidar #iOS #technology #iPhonePro #3Dscanning #augmentedreality #TrueDepth #timeofflightsensor #interiordesign #games

Lidar là gì và nó hoạt động như thế nào trên iOS? Vài năm trước, Apple đã làm lay động thị trường di động bằng cách trang bị cảm biến lidar trên các phiên bản iPhone và iPad mới nhất của họ. Cho đến nay, họ vẫn là những người duy nhất sở hữu tính năng này trên điện thoại của mình. Tuy nhiên, công nghệ này đã có một lịch sử dài lâu, và nhiều điện thoại hiện đại cũng sử dụng các tính năng dựa trên nguyên lý tương tự. Vậy lidar là gì và chúng ta có thể làm gì với nó?

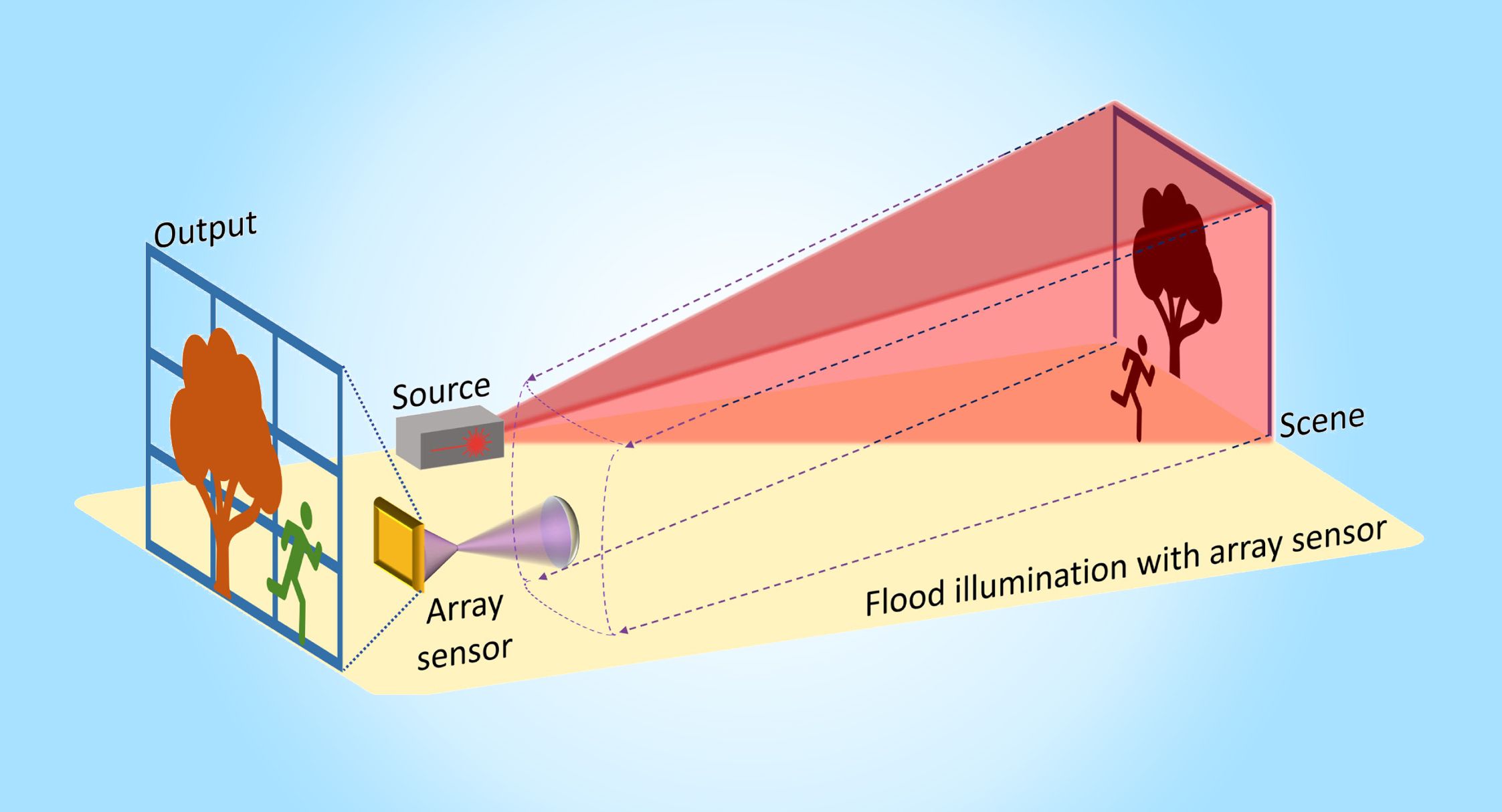

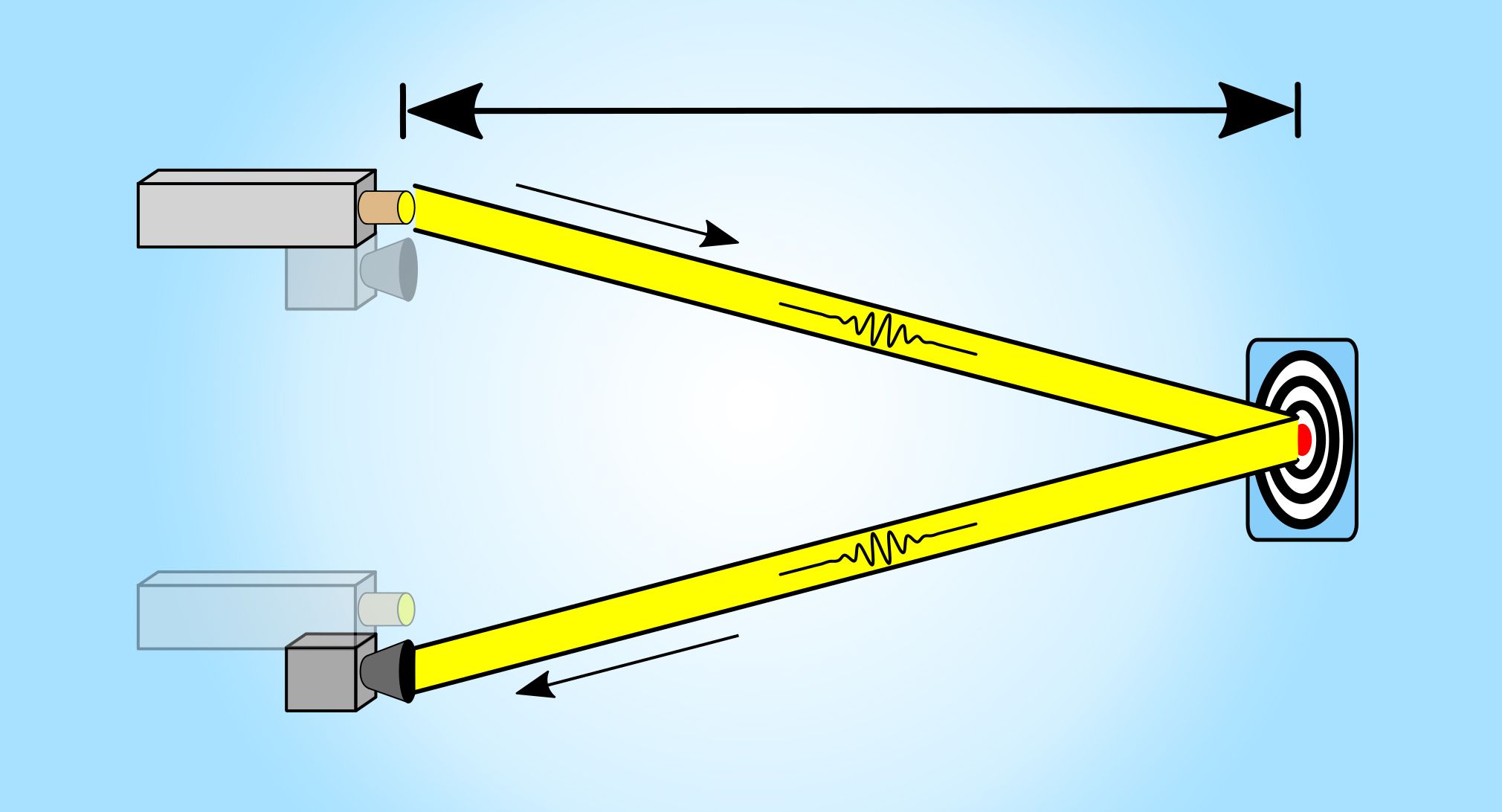

Lidar là viết tắt của LIght Detection And Ranging (Phát hiện và đo khoảng cách bằng ánh sáng) và hoạt động theo các nguyên tắc tương tự như radar. Cả hai hệ thống đều phát ra sóng điện từ một bộ phát và một cảm biến lắng nghe (phát hiện) bất kỳ sự phản chiếu của sóng nếu nó chạm vào một vật thể. Khoảng cách (phạm vi) giữa vật thể phản chiếu và nguồn sóng có thể được xác định dựa trên thời gian giữa việc phát và nhận.

Công nghệ lidar đầu tiên xuất hiện ngay sau khi laser được phát minh vào đầu những năm 1960. Đến những năm 1970, NASA đã sử dụng lidar để đo đạc địa hình mặt trăng. Ngày nay, mọi người đều sử dụng lidar, từ các nhà khảo cổ khám phá thành phố cổ bị lãng quên trong rừng rậm đến các nhà sản xuất xe tự lái đảm bảo các phương tiện của họ có thể cảm nhận được các vật thể phía trước. Và nó cũng xuất hiện trên iPhone Pro mới nhất.

Các điện thoại có laser

Các điện thoại có sử dụng laser bắt đầu xuất hiện từ LG G3 vào năm 2014 khi chúng được sử dụng như các cảm biến thời gian bay để hỗ trợ tự động lấy nét. Đây chính là việc sử dụng lidar cơ bản nhất, trong đó một tia laser hồng ngoại được phát ra để đo khoảng cách đến đối tượng trong ảnh. Thông tin này sau đó được sử dụng để tự động điều chỉnh tiêu cự của máy ảnh.

Ba năm sau đó, Apple ra mắt iPhone X, được trang bị hệ thống camera TrueDepth cho phép tính năng Face ID cách mạng. Mặc dù việc sử dụng nhận dạng khuôn mặt để mở khóa điện thoại không phải là ý tưởng tiên phong của Apple (điều này nên được trao cho Android 4.0 từ năm 2011), nhưng hệ thống TrueDepth của Apple đã thay đổi hoàn toàn trò chơi. Trong khi công nghệ đầu tiên của Android đã trở nên kém an toàn đến mức người dùng có thể sử dụng một bức ảnh để mở khóa điện thoại, công nghệ tiếp cận của Apple lại vô cùng mạnh mẽ. Nó có thể phân biệt được giữa những cặp song sinh trong khi vẫn cho phép đeo kính mắt và mũ nón. Làm thế nào họ đạt được thành công công nghệ này? Bằng laser.

Hệ thống TrueDepth của Apple phát ra một mảng tia laser hồng ngoại có mẫu được cảm biến bởi một camera hồng ngoại và được phân tích bởi phần mềm trí tuệ nhân tạo để tạo ra một quét 3D chi tiết của khuôn mặt bạn trong vài giây. Nó khác với cảm biến thời gian bay vì nó không đo thời gian mà ánh sáng laser trở lại máy ảnh. Nó đo cách mà mẫu tia laser (ánh sáng có cấu trúc) bị biến dạng bởi các vật thể trong phòng cảnh và suy luận dữ liệu 3D dựa trên thông tin đó. Vào năm 2020, ba năm sau khi tung ra hệ thống TrueDepth, Apple giới thiệu hệ thống lidar của mình. Tương tự như hệ thống TrueDepth, nó phát ra một mảng gồm hàng chục tia laser (một lần nữa, theo một mẫu đã biết), nhưng thay vì đo cách ánh sáng biến dạng, một cảm biến chuyên dụng đo thời gian mà mỗi tia mất để phản chiếu trở lại cảm biến. Các đo lường thời gian bay này được kết hợp với dữ liệu từ cảm biến chuyển động và máy ảnh trên điện thoại để tạo ra một quét 3D.

Lidar, nó có tác dụng gì?

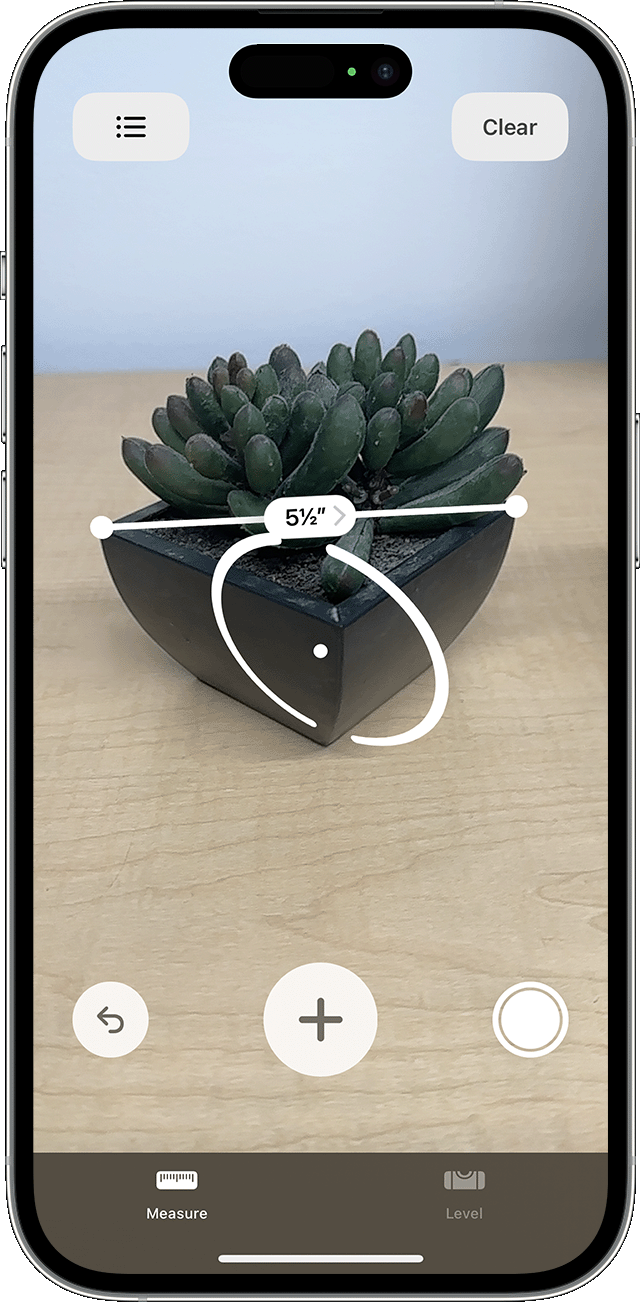

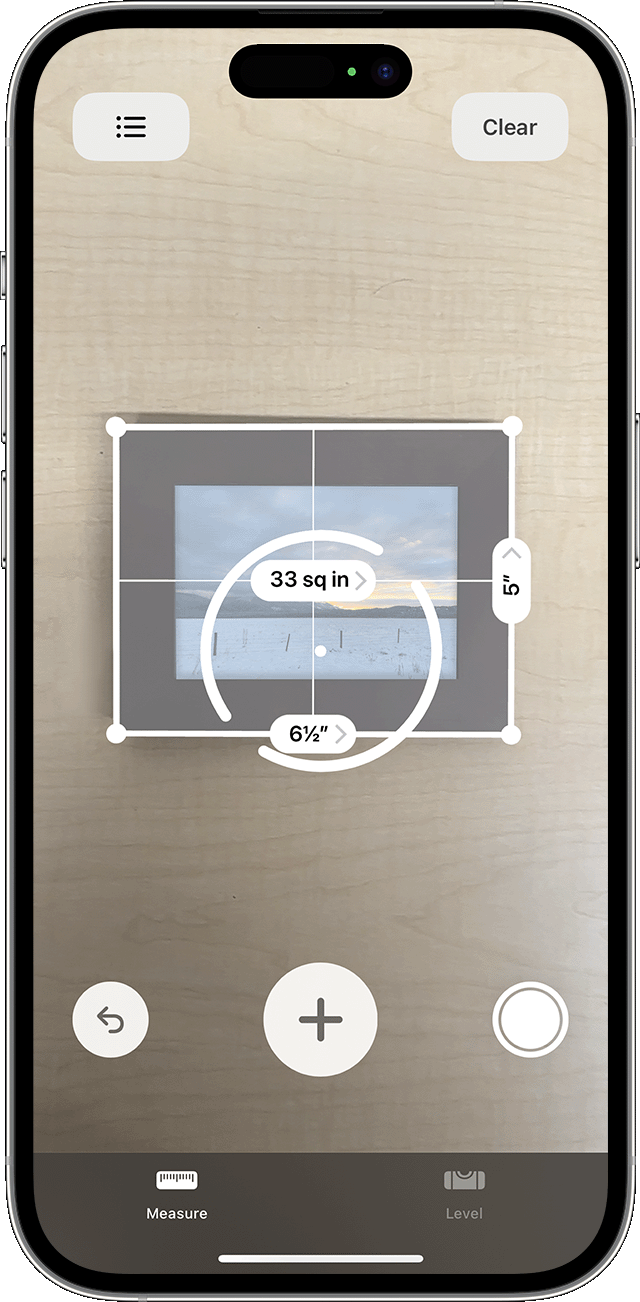

Công nghệ lidar của Apple rất cool, nhưng ta có thể làm gì với nó? Rất nhiều điều, nhưng nó có phạm vi hẹp và không có một số trường hợp sử dụng thay đổi cách chúng ta tương tác với điện thoại của mình. Quan trọng hơn (đặc biệt đối với các nhà sản xuất), nó không có khả năng ảnh hưởng đến quyết định mua điện thoại mới của chúng ta. Việc sử dụng cảm biến thời bay đơn giản của Apple làm cảm biến tự động lấy nét nhanh chóng trên camera mặt sau là một trong những ứng dụng tầm thường nhất của hệ thống lidar của họ. Hầu hết các camera điện thoại trong những năm gần đây đều sử dụng tự động lấy nét dựa trên đối lập hoặc phát hiện giai đoạn để giữ cho hình ảnh sắc nét, nhưng các kỹ thuật này đều yêu cầu đủ ánh sáng để hoạt động. Các cảm biến thời bay không có hạn chế đó, vì vậy các điện thoại có cảm biến này có lợi thế trong nhiếp ảnh thiếu ánh sáng. Apple cũng sử dụng lidar của mình trong một cặp ứng dụng của công ty. Ứng dụng Measure sử dụng dữ liệu lidar, thực tế tăng cường và tam giác học đơn giản để cung cấp các phép đo chính xác về con người và vật thể. Nó cũng có chế độ phát hiện trong ứng dụng Magnier của nó sử dụng trí tuệ nhân tạo và lidar để giúp người có vấn đề về thị lực phát hiện sự hiện diện của cửa hoặc con người và khoảng cách chúng cách xa.

Hầu hết các ứng dụng bên thứ ba sử dụng lidar của Apple nằm trong ba danh mục: thiết kế nội thất, quét 3D và trò chơi thực tế tăng cường. Ikea Place là ứng dụng thiết kế nội thất phổ biến nhất hiện nay. Nó sử dụng thực tế tăng cường để giúp bạn hình dung những sản phẩm Ikea sẽ trông như thế nào trong không gian thực, giảm thiểu sự đoán định xem tấm thảm đó có phù hợp với căn phòng hay không. Nếu bạn quan tâm hơn đến việc đo đạc không gian nội thất của mình, hãy chọn Canvas, nó quét một căn phòng và cho phép bạn xuất dữ liệu vào phần mềm CAD. Đối với những người đam mê in 3D và nhà làm game tìm kiếm mô hình 3D, có Scaniverse và Polycam. Bằng cách quét một vật thể từ nhiều góc độ, bạn có thể xây dựng một mô hình 3D có thể được xuất ra phần mềm thiết kế phổ biến. Việc chọn một trong các ứng dụng này phụ thuộc vào sở thích cá nhân và kích thước của ví tiền của bạn, vì Scaniverse miễn phí, và mặc dù Polycam có một phiên bản miễn phí, một số tính năng của nó bị khóa và chỉ được sử dụng khi đăng ký.

Nếu bạn muốn sử dụng công nghệ mới nhất để chơi game, bạn đã có may mắn. Một trong những trò chơi tốt nhất sử dụng lidar trên App Store là RC Club, cho phép bạn điều

Nguồn: https://www.androidpolice.com/what-is-lidar-and-what-does-it-do/

A few years ago, Apple shook up the mobile market by shipping its latest iPhones and iPads with a lidar sensor. So far, they are still the only players in the game to make this feature available on their phones. However, the technology has a long pedigree, and many modern phones have features based on the same principles. So what is lidar, and what can you do with it?

What is lidar?

Lidar is an acronym for LIght Detection And Ranging and works on the same principles as radar. In both systems, an electromagnetic wave (laser light for lidar and radio waves for radar) is emitted from a transmitter, and a sensor listens for (detects) any reflections of the wave if it hits an object. The distance (range) between the reflecting object and the source of the wave can be determined based on the time between transmission and reception.

The first lidar systems emerged shortly after the invention of the laser in the early 1960s. By the 1970s, NASA was using lidar to measure the moon’s topography. Today, everyone uses lidar, from archaeologists discovering lost cities in the jungle to self-driving carmakers ensuring their vehicles can sense objects in front of them.

Oh, and it’s also on the latest iPhone Pro.

Phones with laser beams

Phones with lasers in them started showing up with LG’s G3 in 2014 when they were used as time-of-flight sensors to help with autofocusing. This is essentially the most basic use of lidar, where one infrared laser is emitted to gauge the distance to the subject of the photo. That information is then used to adjust the camera’s focus automatically.

Source: Wikimedia Commons/RCraig09 CC BY-SA 4.0

Three years later, Apple launched the iPhone X, which had the TrueDepth camera system to allow its revolutionary Face ID functionality. Although using facial recognition to unlock a phone wasn’t pioneered by Apple (that honor should go to Android 4.0 back in 2011), its TrueDepth system completely changed the game. Whereas Android’s first attempt at the tech was notoriously unsecure, such that one could use a photo to unlock a phone, Apple’s foray into the field was remarkably robust. It could distinguish between twins while still allowing for sunglasses and hats.

How did they achieve this technological marvel? Lasers. The TrueDepth system bombards the face with a patterned array of 30,000 infrared lasers, which are sensed by an infrared camera and analyzed by AI software to produce a detailed 3D scan of your face in seconds. It differs from a time-of-flight sensor because it doesn’t measure the time it takes for the laser light to return to the camera. It measures how the pattern of lasers (structured light) is deformed by objects in the scene and infers 3D data based on that information.

In 2020, three years after dropping the TrueDepth bomb on the market, Apple introduced its lidar system. Like its TrueDepth system, it emits an array of dozens of lasers (again, in a known pattern), but instead of measuring how the light deforms, a specialized sensor measures how long each beam takes to reflect to the sensor. These time-of-flight measurements are combined with data from the phone’s motion sensor and camera to produce a 3D scan.

Lidar, what is it good for?

Apple’s lidar technology is cool, but what can you do with it? Lots, as it turns out, but it’s a bit niche, and none of the use cases are the kinds of things that will change the way most of us interact with our phones. More importantly (especially for manufacturers), it’s not likely to influence our decision-making process when shopping for a new phone.

The most mundane use of Apple’s lidar system is as a simple time-of-flight sensor to speed up the autofocus on its rear-facing cameras. Most phone cameras from the past few years use either contrast-based or phase-detection autofocus to keep their images sharp, but these techniques rely on having sufficient light to work. Time-of-flight sensors don’t have that limitation, so phones with these sensors have an edge in low-light photography.

Apple also makes use of its lidar in a pair of first-party apps. The Measure app uses lidar data, augmented reality, and simple trigonometry to give accurate measurements of people and objects.

It also has a Detection Mode in its Magnifier app that uses AI and lidar to help people with vision impairments detect the presence of doors or people and how far away they are.

Most third-party apps that use Apple’s lidar fall into one of three categories: interior design, 3D scanning, and augmented reality games. Ikea Place is the current king of interior design apps. It uses augmented reality to let you visualize how Ikea products will look in situ, taking much of the guesswork out of knowing if that rug will tie the room together. If you’re more interested in taking measurements of your interior space, opt for Canvas, which scans a room and lets you export the data into CAD software.

For 3D printing enthusiasts and game makers looking for 3D models, there’s Scaniverse and Polycam. By scanning an object from multiple angles, you can build a 3D model which can be exported to common design software. Which one to choose comes down to personal preference and the size of your wallet since Scaniverse is free, and although Polycam has a free tier, some of its features are locked behind a subscription.

Source: Scaniverse.com

If you’d rather use the latest technology to play games, you’re in luck. One of the best lidar-activated games on the App Store is RC Club, which lets you drive a virtual RC car around your living room. The lidar scanner means you’ll crash into walls and drive over obstacles. Your virtual RC car even responds to the surface it’s driving on, slowing down when it hits a patch of carpet.

Where to get lidar

Apple’s lidar system is only available on the iPhone Pro and iPad devices released since 2020, so it doesn’t have a wide distribution. Nothing similar exists on Android phones, and standalone systems cost hundreds of dollars. Although this exclusivity is a clear win for Apple, it may also hurt software-based innovation and keep lidar from expanding out of the niche position it currently occupies. On the other hand, the work Apple has done to miniaturize these systems and make them robust enough to be carried around in your pocket means that it might not be long before lidar systems are in every new phone.

[ad_2]